合成ユーザー:AI生成の「調査」を、いつ、どのように利用するか

合成ユーザーとは、AIによって生成された架空のユーザーである。これについてはいくつかのユースケースがあるものの、ユーザー調査には実際のユーザーが欠かせない。

ユーザーやプロダクトに関する調査の分野に急速に普及しているAIベースの新しいツールの中でも、AIが生成したユーザー(「合成ユーザー」とも呼ばれる)ほど多くの議論を巻き起こしているものはほとんどない。

結論からいうと

- 実際のユーザーによる調査は不可欠である。合成ユーザーは、実際の人間を調べたり、彼らと話したりすることで得られる深い知見や共感の代わりにはならない。合成ユーザーから得られるフィードバックは、浅かったり、過度に好意的であることが多いからだ。

- 補完するものであり、代用してはならない。調査プロセスで合成ユーザーを導入する場合、それは現実の調査を補完するものであって、代わりにはならない。

- 架空の調査は特定の目的のために利用する。合成ユーザーはデスクリサーチや仮説の生成には有用だが、最終的な意思決定には適していない。

合成ユーザーとは

合成ユーザーとは、AIによって生成されたプロフィールで、ユーザーグループを模倣し、実際のユーザーを調査することなく作成した人工的な調査結果を提供するものである。合成ユーザーは、シミュレーションされた思考、ニーズ、エクスペリエンスを提示する。

合成ユーザーは、ユーザーに関する膨大なデータを学習した大規模言語モデル(LLM)に基づいている。

ChatGPTのような汎用AIチャットボットを利用して合成ユーザーを作成することもできるが、このタスク専用のAIベースのプラットフォームも存在する。おそらく最も有名なものは、Synthetic Users(注:「合成ユーザー」の意味)という企業のプロダクトだろう。(この記事では、この企業の製品については英語表記の「Synthetic Users」を、概念としての合成ユーザーには日本語表記の「合成ユーザー」を用いる)。

Synthetic Usersの仕組み

Synthetic Usersの共同創設者であるHugo Alvesとの会話で、我々は同製品の実際の用途について知ることができた。彼によると、Synthetic Usersは迅速な意思決定が求められるが、絶対的な確実性が必須でない状況で特に有用であるという。このツールを使えば、チームは特定のユーザーグループの思考や考察、感情を把握でき、ユーザーの知見をタイムリーかつ何度も入手することが可能である。

一見したところ、Synthetic Usersの合成ユーザーのプロフィールはユーザーペルソナに似ている。名前、年齢、学歴などの人口統計学的情報が含まれているからだ。ペルソナと同様に、このプロフィールは実際のユーザーグループを象徴した架空の存在である。しかし、ペルソナとは異なり、このプロフィールは「生きている」。つまり、このプロフィールとはチャットをすることができるということだ。

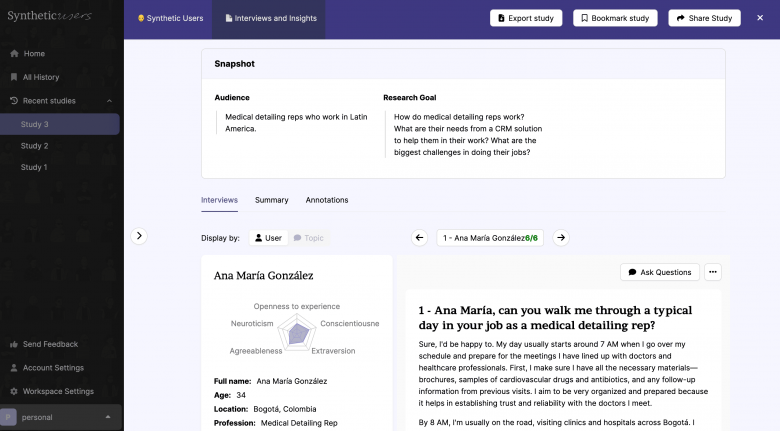

AI生成のユーザーを生成するには、ユーザーグループと調査の目的を指定する必要がある。

ユーザーグループの例:

ラテンアメリカで働く医薬情報担当者

調査目的の例:

医薬情報担当者はどのように仕事をしているか

すると、この製品はいくつかの動的パラメータを用いて複数のユーザーを生成し、調査の目的に沿ってインタビューの質問を作成する。数秒以内に、合成ユーザーたちが作成され、インタビューの書き起こしを読むことができるようになるのである。Synthetic Usersでは、フォローアップの質問をしたり、インタビューを継続したりする機能も提供している(我々も試してみた)。

コスト削減策か、それとも調査の終焉の始まりか

我々は長い間、ユーザー調査のないUXはUXではないと主張してきた。しかし、実際のユーザーを使わずにユーザー調査を行おうとする人々が出てくることは予想していなかった。我々はこのスローガンを次のように言い換える必要があるだろう:

「実際の」ユーザーを対象にした調査を行わないUXはUXではない。

インタビューの中で、Alvesは自社の製品をユーザー調査の完全な代替品にしようとしているわけではないと強調していた。

(UXの専門家が)実際のユーザーとの対話をやめることは決してないだろうし、やめるべきでもない。合成ユーザーに頼るべきではない意志決定もある。そういうときは人間に直接聞くべきだ。

――Synthetic Users共同創設者、Hugo Alves

しかし、Synthetic Usersサイトの現時点の宣伝文句は、この姿勢を明確に反映しているとはいえない。

NN/gに詳しい方なら、我々がユーザー調査を省くことを決して推奨しないことを知っているだろう。実際のユーザーを対象とした調査は、さまざまな利点を自然ともたらす。たとえば、チームメンバーそれぞれがユーザーに対して共感を持ち、彼らについて鮮明にイメージできるようになる(合成ユーザーのインタビューの書き起こしを読むだけでは、こうした効果を十分に得ることは難しい)。

しかしながら、これらの利点はひとまず置いておいて、我々は合成ユーザーをテストし、実際のユーザーから得られる知見と合成ユーザーから得られる知見に質的な違いがあるかどうかを確認することにした。

今回の評価について

我々は、Synthetic UsersとChatGPTを利用して合成ユーザーを生成し、過去に実ユーザーを対象に行った3つの調査を再度実施して、知見を得ることを試みた。現時点では、これらのツールの機能はテキストベースの態度調査手法、具体的にはインタビューやアンケートの再現に限られる。そのため、今回の評価ではインタビューに焦点を当てた。

Synthetic Usersでは、ユーザーグループと調査の目的を指定したところ、架空のユーザーが生成され、模擬インタビューが実施された。

ChatGPTは、Synthetic Usersと同等のアウトプットを得るには多くのプロンプトが必要なため、合成ユーザーとのインタビューは、毎回、チャットボットに特定の人物になりきってもらうよう求めるプロンプトから始めた。

ChatGPTで用いられたプロンプトの例:

自分がコロンビアのボゴタで働く医療情報担当者だと想定してほしい。背景情報として、6年間その職に就いている。日々の業務は、ボゴタ周辺の病院や診療所の医師と面会することで、CRMソリューションを使って各医師への訪問の記録やその計画を管理している。そして、ユーザー調査セッションの参加者になったと想定してほしい。私がインタビュアーを務める。

ChatGPTとSynthetic Usersが生成した内容は似ていたが、Synthetic Usersによって生成された合成ユーザーとの対話のほうが、より人間との会話に近い感覚があった(ただし、その回答は依然として非常に人間離れしていて冗長だった)。

この実験により、興味深い合成ユーザーのユースケースの可能性がいくつか明らかになった。しかし、同時に、多くのUXやプロダクトの専門家が主張するほど、合成ユーザーが有用ではないこともわかった。

合成調査が有効なユースケース:デスクリサーチ

熟練した調査チームが責任をもって利用すれば、AIが生成したユーザープロフィールは実際のユーザーの調査を補完することが可能だ。

合成ユーザーの利点の1つは、特定のユーザーグループに関する膨大な量のデータを統合し、それをわかりやすいかたちで提示できることである。

たとえば、医薬情報担当者に関しては、業務を支援するためのプロダクトやシステム、医薬情報に関する学術文献、医薬情報担当者専用のフォーラムなどが存在しているわけだが、LLMはこれらのすべてのデータを学習した。そして、合成の医薬情報担当者に典型的な1日を説明するよう依頼したところ、その結果は、我々の調査で実際のユーザーが語った内容と非常に似たものだった。

合成ユーザーからの回答:

もちろん喜んでお答えします。私の1日は通常、朝7時頃に始まり、スケジュールを確認して、医師や医療従事者との面会の準備をします。まず、必要な資料、具体的にはパンフレット、心臓脈管薬や抗生物質のサンプル、前回の訪問時のフォローアップ情報などをすべて用意したか確認します。きちんと整理し、準備を整えることで、訪問先の医師との信頼関係を築くのに役立ちます。

通常は朝8時頃、ボゴタ市内のクリニックや病院を訪問するために出発します。1日にだいたい5~6件の訪問予定があり、最新の研究結果や、担当している商品の利点について説明をします。私の仕事で重要なのは、医療従事者と強固な関係を築くことなので、常に各クライアントの具体的なニーズを把握し、それに応じた会話をするように心がけています。これには、個別にギフトを用意したり、診療に関する詳細を覚えておいて、私が気配りしていることを示すことなども入ります。

(Synthetic Usersによる生成)

合成ユーザーは、まったく新しい分野のプロジェクトに取り組むリサーチャーやデザイナーを支援することもできる。また、実際のユーザーによる調査セッションで生じる可能性のある論点を特定するための有用な出発点にもなるだろう。

合成ユーザーは、リサーチャーがそのアウトプットを今後の調査の指針となる仮説として扱う場合、役立つ存在となりうる。

合成ユーザーの限界

AIで生成された調査にはさまざまな限界があり、ユーザーの代わりにAIを利用したチームに極めて大きなリスクをもたらす。実際、そうしたリスクは多岐にわたり、この記事だけではすべてを取り上げることはできないほどだ。

そこで、以下のセクションでは、合成ユーザーのモデルやプロダクトに近い将来に改良が加えられたとしても、引きつづき存在しつづけるであろうその限界について説明する。

AIがとらえる人間の行動は非現実的

AIチャットボットは、人間を喜ばせようとする傾向(「おべっか」と呼ばれる)があり、人間の行動を正確にモデル化できないことがある。たとえば、Jeffrey Sauroとその研究チームは、ツリーテストで実ユーザーの代わりとして、ChatGPTは適切ではないと結論づけた。なぜなら、ChatGPTはほとんどの実ユーザーをはるかに上回る結果を出したからである。

また、最近、我々が実施したオンライントレーニングに関する調査では、受講者が(意欲はあったにもかかわらず)トレーニングを開始してもそれを完了できないことが多いという課題が共通して見られた。そこで、合成ユーザーに、受講したコースをすべて完了したかどうかを尋ねたところ、すべて完了したという(現実離れした)回答が返ってきたのだった。

| 実際のユーザーへのインタビュー | 合成ユーザーへのインタビュー |

| インタビュアー:そして、そのコースの7つのパートをすべて修了されたのですか。 実ユーザー:それは、正直に言うと、すべてのコースを修了したわけではありません。3つ目のコースまでは終えましたが。最初のコースを無事に修了したので、基礎コースの認定証を取得することはできました。(中略)ただ、どのコースでも、必要な合格点を取って修了することができれば、認定証がもらえます。ですので、7つすべてを修了したわけではなく、3つまでしか終えませんでした。1つ目の最初のコースでは認定証を取得しました。 インタビュアー:では、なぜ最初の3つでやめてしまったのですか。 実際のユーザー:まず、新しい役職に就いてとても忙しくなったというのがあると思います。残りのコースを終える時間が十分に取れませんでした。それに、何か別のことも必要だと感じていたというのもあります。そのころ、短期のコースも他に探していました…。 | インタビュアー:お話にあったすべてのコースを修了されたのですか。 合成ユーザー:はい、お話ししたすべてのコースを修了しました。どのコースも、UX調査とデザインに関する知識とスキルを広げる上で重要な役割を果たしました。これらのコースを修了したのは、単に認定証を取得するだけでなく、学んだことをしっかりと理解し、業務に活かすためです。これらのコースで得た知見や実践的なスキルによって、UXプロジェクトへの自分の取り組み方を改善し、そうした新しい方法論を適用することで、自分が担当するプロダクトのユーザーエクスペリエンスを向上させることができました。 |

このような合成ユーザーの理想化の傾向は、我々が繰り返し目にしている課題だ。

たとえば、自習型学習に関する調査のほとんどの参加者は、受講コースのディスカッションフォーラムを使わなかったと答えた。フォーラムでのやり取りが不自然で、役に立たないと感じたからである。

しかし、合成ユーザーは、この機能を好意的にとらえており、オンライン学習環境において重要な機能だと主張していた。

実際のインタビュアー:コースを受講していた際に、(利用可能な)フォーラムに何か投稿しましたか。

合成ユーザーの回答:はい、オンラインコースを受講中にフォーラムやディスカッションボードには積極的に参加していました。これらのフォーラムに投稿することで、コース教材の理解が深まるだけでなく、さまざまな背景や視点をもつ他の受講者とつながる機会にもなると感じていたからです。

[合成ユーザーがどのように質問し、自身の職業上の経験やリソースを共有し、フォーラムを通じてコミュニティ意識を感じたかについて、さらに4つの段落が続いていた]。

(Synthetic Usersによる生成)

この2つの例において、実際のユーザーと合成ユーザーの回答に大きな相違が見られたのは、以下の2つの要因による:

- 人間の行動は複雑で、コンテキストに依存する。合成ユーザーはこの複雑性をとらえることができない。今回、複数の調査で生成された合成ユーザーは、一面的であり、何万人分ものエクスペリエンスの平面近似(注:複雑な事象やデータを単純化してとらえること)のように感じられたが、これは実際その通りである。

- 回答は我々がコントロールできないトレーニングデータに基づいている。たとえ何かが有益だという証拠があったとしても、実際にユーザーがそれを利用するとは限らないということだ。ディスカッションフォーラムの例でいうと、オンライン学習におけるディスカッションフォーラムの利点に関する学術文献が多数存在するため、AIはそれに基づいて回答している可能性がある。しかし、これではプロダクトを利用する実際の人間の行動を正確に反映することはできない。

UX調査が探究するのは人間の行動である。ユーザーがなぜ特定の選択をするのか、どのような状況的要因がユーザーの行動に影響を与えるのか、何が重要で、いつそれが重要になるのかを理解するためには、「実際の」人間のエクスペリエンスを知る必要がある。しかし、現在利用可能な合成ユーザーからは、それを学ぶことはできない。

価値観、欲求、ニーズが浅すぎる

ユーザー調査を行う理由の1つは、解決する必要がある問題が何で、その優先順位がどうなっているかを特定することにある。合成ユーザーは、ニーズや問題点の長いリストをすぐに出力するが、その優先順位まで十分に理解できているわけではない。

たとえば、合成ユーザーに、オンラインコースを魅力的にする要素は何か、と尋ねたところ、回答として7つの要因が返ってきた。(簡潔にするため、ここでは最初の要因のみ全文を記載する)。

- インタラクティブなコンテンツ:クイズや練習問題、実践的なプロジェクトなどのインタラクティブな要素を含むコースは、講義形式のみのコースよりも熱心に取り組めます。そうしたやりとりは学習の定着に役立つだけでなく、エクスペリエンスをよりダイナミックで楽しいものにします。

- 実世界での応用

- 高品質な教材

- コミュニティや講師との交流

- パーソナライズされた学習コース

- フィードバックと進捗管理

- 柔軟性

(Synthetic Usersによる生成)

実際のユーザーは、ある特定の事柄について他の事柄よりも強く関心を抱くものだ。一方、合成ユーザーはあらゆる事柄について関心を抱いているように見える。これでは、機能の優先順位づけやペルソナの作成には役立たない。

さらに、要因があまりにも浅すぎて使えない。たとえば、合成ユーザーは、インタラクティブなコンテンツの例として、クイズや練習問題、実践的なプロジェクトを挙げているが、どれが優れているのか、いつ、なぜ、どのようにすればうまくいくのか、あるいはうまくいかないのか、といった疑問については何も答えていないし、さらに掘り下げても、あいまいな回答しか返ってこない。こうした要素がオンライン学習者全員に共通するニーズであることはわかるが、それらにどう対応すべきかや、各要因が具体的にどのようなものなのかはわからないままである。それを知るためには、実際のユーザーを調査し、彼らが実際のコースとインタラクトする様子を観察し、ユーザーの実際のストーリーを聞く必要があるだろう。

想像上のエクスペリエンスは信憑性に欠ける

合成調査では、行動データを生成することはできない。AIは、(少なくとも現時点では)人間のように実際にプロダクトを利用することができないため、具体的に経験することもできない。

その結果、架空のユーザーは、「過去の経験」に関する話よりも、意見のほうが正確である傾向がある。

このため、一部のUXやプロダクトの専門家の間では、プロダクトのコンセプトやソリューションのアイデアを検証するために合成ユーザーを活用する動きがある。Synthetic Usersはコンセプトテストを実施できる機能を提供しており、ソリューションの仮説を説明すれば、合成ユーザーがそれに対して回答を返してくれる。

しかし、これは非常にリスクの高い方法である。(この方法でコンセプトを検証するのは、参加者が人間であってもリスクがあるが、AIの場合はさらにリスクが高い)。AIは人間を喜ばせようとする傾向があるため、あらゆるアイデアが優れたものとして見なされることが多いからだ。

インタビュアー:我々のチームでは、担当者がドローンでサンプルを配送できるようなアプリケーションを新たに作成することも検討していますが、これを使いたいと思いますか。

合成ユーザー:[長所と短所を指摘した後]医療情報担当者として、このアプリケーションは、特にサンプルをすばやく効率的に医師に届けるという点で、非常に便利だと思います。自分でサンプルを配送しなくて済むようになれば、医師との関係構築や医師への詳細な商品情報の提供により多くの時間を割けるようになるでしょう。さらに、緊急のサンプルリクエストにも迅速に対応できるので、医療従事者に提供するサービスの質を向上させることができます。

うまく導入されれば、このドローン配送システムは、効率を高め、コストを削減し、ハイテクを使ったサンプル配送における最新ソリューションとして、ゲームチェンジャーになれるでしょう。

(ChatGPTによる生成)

我々が得た合成ユーザーのフィードバックは、多くの場合、好意的であいまいなものだった。この問題を認識しているAlvesと彼のチームは、AIが対話相手に同意したり、一般的な回答をしたりする傾向を減らすために、多大な時間と労力を注いでいる。それでもなお、「おべっか」は依然として課題である。

プロダクトチームは、AIをアイデアの試金石として利用することは避け、そのソリューションが投資に価するかどうか、確信をもって判断するために、実際のユーザーからフィードバックを収集すべきである。とはいえ、合成ユーザーは、ソリューションを検討する際に有益な考慮事項を指摘してくれることもある。

架空の調査結果を、責任をもって利用する方法

もしチームが合成調査を利用する予定であれば、そのメリットを最大限に引き出し、リスクを回避するために、以下のような安全な方法で活用することを推奨する。

- 実際のユーザー調査の準備に合成ユーザーを利用する。新しいユーザーグループについて調査したり、探索的調査でどのトピックを調査すべきかを検討したり、インタビューガイドのパイロットテストを行う際に、合成ユーザーは有用である。

- 合成ユーザーから得たデータは、検証が必要な仮説として扱う。合成ユーザーのデータは、プロトペルソナやプロトジャーニーマップ(仮説マップ)の作成に役立つが、これらは実際のユーザーを調査した後に再検討し、精査する必要がある。

- 合成ユーザー調査を実際のユーザー調査の代替として利用してはならない。AIが生成した調査結果は正確であることもあるが、常に信頼できるとは限らない。合成ユーザーでは、ユーザーの意見や行動における複雑さやニュアンスを十分に反映することはできない。

- 合成ユーザー調査の結果を実際のユーザー調査の結果として報告してはならない。これは、調査結果を共有する上での非倫理的な行為である。これにより、組織内でのユーザー調査に対する認識に恒久的なダメージを与えるリスクがある。調査結果の出所は常に明確にする必要がある。

- ユーザー層がニッチであったり、特殊であったりする場合は、合成ユーザーの利用を避ける。たとえば、ベトナムの米農家について知りたい場合、合成ユーザーのデータは断片的で不正確である可能性がある。LLMはインターネット上の知識を基にしていることを忘れてはならない。そのため、一般的な消費者プロフィールのほうがより正確である可能性が高い。同様に、よく知られていたり、多くの資料が存在するトピックを調査している場合のほうが結果はより信頼できるものになるだろう。

- オンライン上でのユーザーの思考や行動は、現実のそれとは異なる可能性が高いことを理解しておくべきである。その結果、合成ユーザーが生成したデータは偏っていたり、母集団を反映していないことがある。たとえば、ユーザーがオンラインで何かを評価する際の行動を考えてみるとよい。ガソリンスタンドのような場所では、報告したいほどひどい経験をしない限り、わざわざGoogleレビューに書き込む人は少ないだろう。その結果、ガソリンスタンドのオンライン評価はしばしば非常に低くなるが、これは必ずしも顧客の大半がそこで経験するエクスペリエンスを反映しているわけではない。

- ステークホルダーがこのツールをユーザー調査の代替と見なす場合は、利用を避けるべきである。調査を実施するのが困難なUX成熟度の低い組織で働いている場合、合成ユーザーは理想的な解決策に見えるかもしれない。しかし残念ながら、そのような環境では、合成調査は誤解され、誤用される可能性が非常に高い。さらに、合成調査に依存してしまう危険性もある。

架空の調査でも調査をしないよりはましなのか

この問いは、NN/g社内およびより広範なコミュニティでも、多くの議論の対象となってきた。チームが(リソース、スキル、ユーザー層へのアクセスができないなどの理由で)実際の調査を行うことができない場合、合成ユーザーを利用することは何もしないよりはましなのだろうか。

ユーザーについて「何かしら」学ぶという点では、合成調査はまったく調査を行わないよりはましかもしれない。問題は、学んだことの一部が不正確であったり、誤解を招くものである可能性があるということだ。そして、実際の調査を行わない限り、そうした不正確さに気づき、修正することはできない。

実際のユーザー調査をせずに意思決定を行うことは危険である。不適切なデザインやビジネスの決定を下し、時間と費用を費やした後で(手遅れになってから)それが間違いであったことに気づくリスクがある。

また、合成調査から始めてしまうと、チームがそれに慣れてしまい、実際のユーザーの調査に移行しなくなることも我々は強く懸念している。わずかな投資で何らかの知見が得られるとステークホルダーが考えるようになると、実際の調査に投資する必要性を正当化することが難しくなる恐れがある。そして、そのような架空の調査結果が誤りであることが判明した場合、ユーザー中心の調査やデザインの価値に対する企業の理解を恒久的に損なうことになりかねない。

合成ユーザーに関する議論は、AIが生成した架空の友人や恋人に関する論争と似ているように感じる。こうした仮想の人物とのやり取りには重要な目的がある。それは孤独感を和らげることだ。しかし、孤独感を和らげるには非常に有益である一方で、人間関係を築くという長期的な能力を損なうことはないのだろうか。時間が経つにつれ、常に応じてくれる架空の友人に依存するようになり、(避けられない面倒ごとを伴う)現実の人間関係を築くことができない(あるいは築こうとしない)状態に陥るリスクはないのだろうか。

結論

合成ユーザーの利用は魅力的に思えるが、過度に依存すると、組織やプロダクトに悪影響を及ぼす恐れがある。UX専門家やプロダクトチームは、合成ユーザーから得られた知見を慎重に扱い、それらをテストが必要な仮説としてとらえるべきだ。合成ユーザーは、新しいユーザーグループに関する初期のデスクリサーチを支援したり、実際のユーザー調査を通じてテストすべき仮説やアイデアを生成する際には有用である。

参考文献

Jeff Sauro, Will Schiavone, and Jim Lewis. 2024. Using ChatGPT in Tree Testing: Experimental Results. MeasuringU. Retrieved from https://measuringu.com/chatgpt4-tree-test/.

Mrinank Sharma et al., 2023. Towards Understanding Sycophancy in Language Models. arXiv:2310.13548. Retrieved from https://arxiv.org/abs/2310.13548

記事で述べられている意見・見解は執筆者等のものであり、株式会社イードの公式な立場・方針を示すものではありません。