AIを利用したUX調査ツール:課題と限界

UXリサーチャーのためにデザインされたAIツールの宣伝文句には懐疑的になろう。そうしたシステムの多くは、宣伝文句にあるすべてのことが実行できるわけではないからだ。

ChatGPTが呼び起こした関心を利用しようと、あらゆる種類の新しいAIツールが市場に参入している。UXの分野もその例外ではない。

UX調査のためのAIを利用ツールの宣伝文句は、以下のような大げさなものだ:

- 「調査の分析をあなたに代わって行います! データの分析もタグづけも不要です」。

- 「AIにはバイアスがありません! 調査のバイアスを軽減しましょう!」

- 「弊社のツールは、ユーザビリティテストを含む、あらゆるユーザー調査手法のデータを分析できます!」

こうした謳い文句が出来すぎのように聞こえるとしたら、その理由はそのとおりだからだ。将来的には、AIを利用したユーザー調査ツールは、この種の約束をより的確に実現できるようになるだろう。しかし今は、これらのツールの導入を検討する際には慎重になる必要がある。

今回、AIを利用した4つの新しいUX調査ツールを評価した。この記事では、その評価結果を紹介する。どのツールについてもその名前には言及していないことに注意してほしい。近い将来、失敗から学んで改善されることを期待しているからだ。

AIを利用したUX調査ツール

現在市販されているAIを利用したツールには2つのタイプがある:

- 知見生成ツール

- コラボレーションツール

両者はともに定性調査セッションの書き起こしの要約に利用できる。

AI知見生成ツール

AI知見生成ツールは、ユーザー調査のセッションをセッションの書き起こしだけに基づいて要約する。

このツールは、リサーチャーからの他の種類の情報を受け付けない。これは、最終的には大きな問題となる。人間のリサーチャーとは異なり、このツールはコンテキストを考慮することができないからだ。つまり、製品やユーザーについての背景情報を受け付けないということだ。また、過去の調査の結果を活用することも不可能である。

(リサーチャーは、分析に追加するために背景情報や自分自身のセッションメモを別の要素としてアップロードすることで、この制約を回避することができるかもしれない。しかし、これらの情報は、セッション固有の情報ではなく、別の情報源として扱われる可能性もある。一方、人間のリサーチャーであれば、容易にこの2つの情報をインタビュー内容と組み合わせることができるだろう)。

AIコラボレーションツール

AIコラボレーションツールは、知見生成ツールと似ているが、リサーチャーからのコンテキスト情報を受け入れることができる点が異なる。知見生成ツールのように、コラボレーションツールはテキストデータを吸い上げ、知見を生成することができる。

たとえば、リサーチャーは、人間が作成したコードをこのAIに示して、AIを「訓練」することが可能だ。そうすると、このツールは、データの主題分析のためのタグを推奨することができるようになる。また、セッションの書き起こしだけでなく、リサーチャーのメモを分析することも可能である。このようにコラボレーションツールは(一般的な知見生成ツールとは異なり)複数の情報源からの入力に基づいてテーマや知見を生成することができる。

AIコラボレーションツールは、AI知見生成ツールよりも高度なものだ。しかし、依然としてAI知見生成ツールと同様の限界(後述)を抱えている。

AIを利用したツールの評価方法

今回、3つの知見生成ツールと1つのコラボレーションツールを調査した。この記事を書いた時点では、3つの知見生成ツールのうち、2つはユーザー調査のデータを扱うには時期尚早と判断した。(というのも、その1つは、指定されたプロジェクトの上位5個の知見のリストを生成するだけで、プロンプトを修正したり、フォローアップの質問ができる機能もなかった。もう1つは、リサーチャーがテキストファイルしかアップロードできず、ほとんどのユーザー調査プロジェクトにとって機能が限定されすぎているように思われた。ただし、アプリストアのレビューのような大量のテキストの分析には適しているかもしれない)

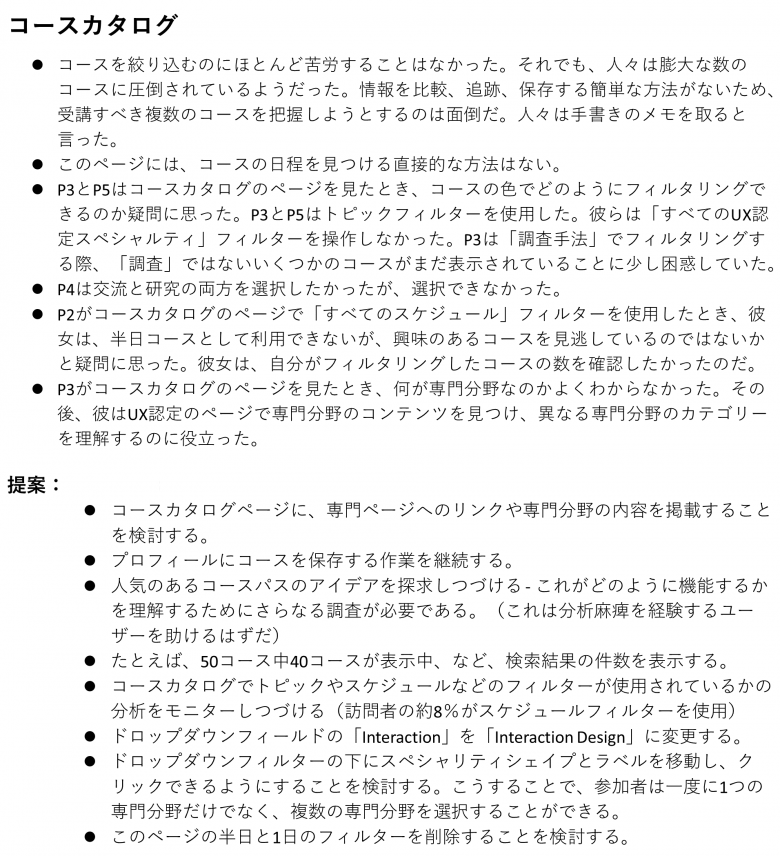

これら以外の2つのツールを評価するために、我々がアップロードしたのは、NNgroup.comのユーザビリティテスト調査の記録である。そして、こうしたツールによる分析と、人間のリサーチャーによる分析を比較した。そのテスト調査の目的は、モバイルユーザーがNN/gのトレーニングコースをどのように選択するのかを知ることだった。調査のデータは、NN/gのリサーチャーによってすでに分析済みだったが、そのユーザーテストセッションを最初に分析したリサーチャーは誰も、今回のAIに関する評価には参加していない。

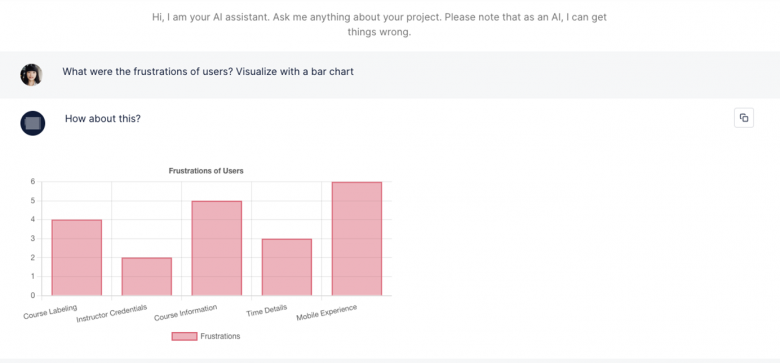

さらに、セッションの最初の主題分析から得たタグを(タグの入力を受け付ける)そのコラボレーションツールに入力した。

今回調査したツールのアウトプットは以下である:

- 1つのドキュメント(セッションの動画やメモなど)、あるいはコラボレーションツールの場合は、タグ付けされた複数のテキストに基づく、知見のリスト

- AIチャットツールで送信した質問に対するフォローアップ回答(例:「ユーザーはどんな不満があったのか。棒グラフで可視化して」。)

- タグレコメンド(コラボレーションツールのみ)

課題と限界

ほとんどのAIツールは視覚情報を処理できない

我々がテストしたAI調査ツールの中には、動画や視覚情報を処理できる機能を備えているものはなかった。どれも完全にテキストベースであったため、そうしたツールが分析できるのは書き起こしのデータだけだった。これは、ユーザーインタビューを分析する上では大きな問題ではない。しかし、これらのツールの作成者によるばかげた主張とは異なり、どんな人間もAIツールも、書き起こしデータだけでユーザビリティテストのセッションを分析することは不可能だ。

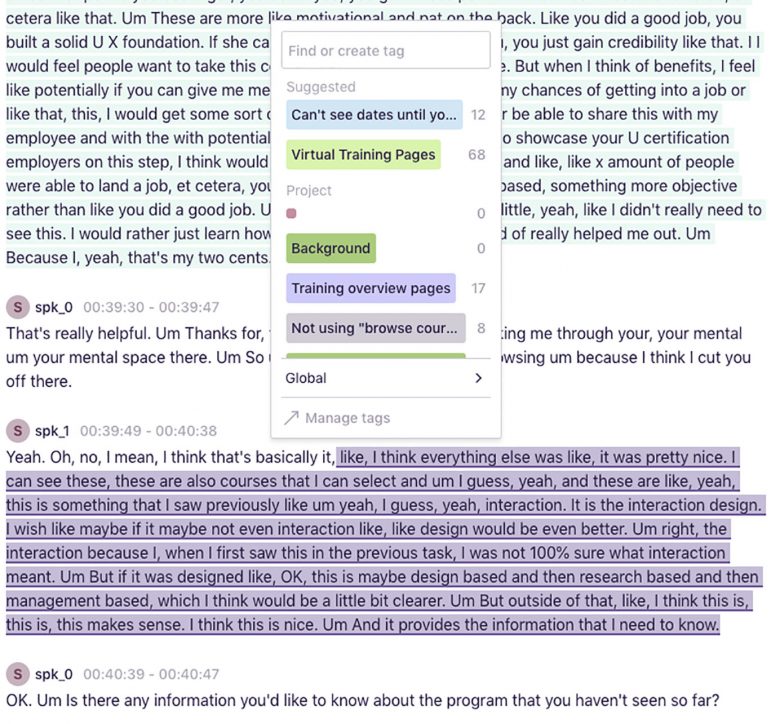

ユーザビリティテストとは、そもそも、ユーザーが製品とどのようにインタラクトしているかを観察することに依存する手法だ。参加者は、多くの場合、思考発話をすることで、自分が今、何をしていて、何を考えているのかを説明する。彼らの言葉からは貴重な情報をまさに手に入れることができる。しかし、参加者の発言だけに基づいてユーザビリティテストを分析するのは禁物だ!

書き起こしだけを用いて分析すると、ユーザーテストの重要なコンテキストを見落とししまうからだ。なぜならば、参加者は:

- 時として最も興味深いこともある、特に小さなマイクロインタラクションなど自分の行動をすべて言葉にするわけではない。また、訪問するすべてのページや画面、あるいは実行するすべてのクリックを声に出して宣言してくれるわけでもない。その結果、ユーザーがその時点で見ているページや画面をAIツールがわからなくなってしまうことは多い。

- 製品のすべての要素を説明しない。あるデザイン要素がユーザーテストの書き起こしに出てこない理由はいろいろある。たとえば、その要素が一般的なもので、期待どおりに機能したというのもそうだ。あるいは、その要素がそのインタフェースには表示されていなかったことも考えられる。AIがそのデザインを「見る」ことができなければ、本当の理由を知ることは不可能だということである。

- 製品のメンタルモデル、または、明確な理解が常にあるとは限らない。参加者がデザインの特定の側面を間違って解釈している可能性もある。もしAIツールが参加者の誤解を事実として受け入れてしまうと、そのツールは製品を理解できなってしまうだろう。

あるセッションについてAIが生成した全体サマリーの中で、そのAIツールは我々がテストしたサイトにフィルターを追加することを提案した。そのWebサイトには、「実際には」フィルターツールを備えたページもあった。しかし、そのときの参加者は、調査中、フィルター機能を実際には使っていたのに、その機能について口に出して言うことをしなかった。一方、彼女は、別のページではフィルターの必要性を訴えたのだった。

その結果、フィルターを追加するようにというAIツールの提案は混乱を招くものとなった。そのページにもっとフィルターが必要だったのか。それとも、すべてのページにフィルターツールがあるべきなのだろうか?(こうした提案は、AIが生成した知見によく見られるもう1つの問題点である、「あいまいさ」の例といえる。あいまいさについて詳しくは次のセクションを参照のこと)。

ユーザビリティテストのセッションの書き起こしだけで分析できる、と主張しているAIツールを信用してはならない。今後、映像を処理できるツールが登場すれば、そのツールはこの手法での分析にもっと役立つだろう。

あいまいな要約と提案

AIツールによる要約や提案は極めてあいまいなことが多かった。

たとえば、あるツールがとある説明ページについて行った提案は以下のようなものだった:

「すべての関連情報に容易にアクセスでき、そうした情報が明確に表示されているようにしましょう」。

「(そのページに関する)より詳細な説明を提供しましょう」。

この提案は悪くないように思える。しかし、「関連情報」や「詳細な説明」が何を意味するのか、また既存のコンテンツをどのように修正すれば「明確に表示されるのか」についての説明はない。

以下は、2つの分析結果からの抜粋である。1つはAIツールによって生成された分析、もう1つは人間のリサーチャーによって書かれた分析である。

限定的なコンテキストの理解

AI知見生成ツールは、コンテキストがほとんど欠落している。このツールは以下のようなコンテキストを要求しないし、受け入れることもできないからだ:

- 調査目標や調査の課題

- これまでの調査から得られた知見やタグ

- 製品やユーザーグループについての背景情報

- 各参加者についてのコンテキスト情報(例:新規ユーザーか既存ユーザーか、など)

- タスクやインタビュー質問のリスト

任意のプロジェクトに情報をアップロードできるようになっているツールもある。しかし、リサーチャーがこれらのリソースを使い分けることができないことには注意する必要がある。たとえば、調査目標はすべてのセッションに引き継がれるべきである。しかし、セッションごとの参加者の情報は特定の動画にだけ適用されなければならないはずだ。

こうしたコンテキストの欠如は、AI知見生成ツールが生成する分析に問題を引き起こす。たとえば、知見は、優先順位づけされないまま提示されてしまう。調査目標を理解していないシステムは、何がリサーチャーにとって最も重要で関連性があるのかを判断することができないからだ。

実際、AI知見生成ツールによって生成されたテーマのなかには、きわめて情報量が少なく、興味をそそらないものもあった。あるAI知見生成ツールから得られた結果は以下のようなものだったのである:

「参加者は、肯定的なフィードバックも否定的なフィードバックも伝えることができ、満足していた」。

これが結果の一覧のトップに表示されたというわけだ。このような無意味な所見をプレゼンテーションに入れたり、レポートに載せたりすることを想像してみてほしい!

有益な知見が的外れな知見の海に埋もれている場合、有益なものだけを特定し、優先順位をつけるには多大な時間を必要とする。手作業でセッションを分析する以上に、だ。

引用元と検証の欠落

引用や提案をする際、一部のツールはその情報がどこにあるかについて触れることをしない(たとえば、引用を特定のセッションに関連づけたり、タイムスタンプを入れたり、参照しているクリップにリンクさせたりしない)。

皮肉なことに、こうした参照元の欠如は、リサーチャーからのコンテンツを受け入れることができるAIコラボレーションツールに多くの問題を引き起こす。たとえば、我々がテストしたツールでは、リサーチャーのメモとセッションの書き起こしを区別することが不可能だった。これは、調査の報告時に大きな倫理的問題となる。我々は常に、自分たちの解釈や仮定と、参加者の言動を区別する必要があるからだ。

最も重要なのは、引用元の記載がないために、ツールが生成した要約や提案が調査からもたらされたものかどうかをリサーチャーが検証できないということだ。AIシステムには、もっともらしく聞こえる間違った情報を提供するという危険な傾向がある。AIツールが、ある製品に特定の新機能を追加するように提案してきたが、その提案はユーザー調査データに基づいたものではなかったとしたらどうだろう。このような間違いは、時間とリソースに損失をもたらす可能性がある。

我々が評価したツールの中には、情報の正確性に関する免責事項を記載しているものもあった。だが、興味深いことに、そのような免責事項はそうしたツールの宣伝広告ではどこにも見あたらないことが多かった。

不安定なパフォーマンスとユーザビリティの問題

残念ながら、今回、テストしたツールに安定したユーザビリティとパフォーマンスを備えているものはなかった。我々は、機能停止やエラー、不安定なパフォーマンスに直面した。何度もカスタマーサポート部門に問い合わせなければならないツールもあった。基本的な機能を使おうとしただけだったのに、である。このような問題は、分析をスピードアップさせるどころか、むしろスピードダウンさせかねない。

バイアス

他にも、AIを利用した調査ツールによる疑わしい主張には、以下のようなものがある:

「弊社のツールは、バイアスを入れずにユーザーの視点を提供します。AIシステムにはバイアスがないからです」。

ひょっとしたら、AIツールを使うことで、バイアスをある意味では減らすことができるかもしれない。たとえば、自分たちのデザインをテストする場合、無意識のうちに確証バイアスの影響を受けやすい。しかし、AIツールは、あなたのデザインが期待通りに機能するかどうかを気にしないだろう。

しかし、AIツールにはバイアスがない、という主張は明らかな誤りであり、この技術がどのように機能するかについての間違った認識である。NISTのReva Schwartzとその研究チームによれば、AIシステムやアプリケーションには、系統的なバイアス、統計や計算におけるバイアス、人間によるバイアスという3つのレベルのバイアスが入る可能性があるという。AIの学習はデータを用いて行わなければならないが、その際、系統的なバイアス(歴史的、制度的なものなど)や統計的なバイアス(たとえば、データセットのサンプリングの代表性が不十分であるなど)が生じる可能性がある。また、AIを利用したツールによる結果を意思決定に利用する場合、アンカリングバイアスのような人的バイアスを持ち込んでしまう可能性もある。

OpenAIのようなAI企業は、可能な限り潜在的なバイアスを減らすよう努力しており、これは本当にありがたいことだ。それでもなお、AIを利用したツールのユーザーは、こうしたバイアスに注意する必要がある。

AIを利用した調査ツールの将来像

我々は、近い将来、ユーザーリサーチャーが、信頼でき有用で優れたAI駆動ツールを手に入れられると信じている。そうしたツールは、我々の仕事をスピードアップし、質を高めてくれるだろう。しかし、現在利用可能なツールは、まだそのようなメリットを提供できていない。

我々は、この種のツールに将来、以下のような機能が追加されることを希望し、期待している:

- 調査の目標、調査課題、参加者情報、過去の調査結果など、さまざまな種類の背景やコンテキストの情報を受け付ける機能。

- リサーチャーからの編集や修正を受け入れる方法。こうしたツールは、(特に、書き起こしに依存している現状を考えると)より柔軟性を備え、人間のリサーチャーと連携する必要がある。最終的には、AIシステムは人間からの指示をあまり必要としなくなるだろうが、現時点では、これらのツールを少しでも有用なものにすることが肝要である。

- 正確で、具体的で、リンクが張られている参照元。リサーチャーは、AIシステムの作業をすばやく容易にダブルチェックできる方法を必要としている。つまり、特定のセッションからであろうと、オブザーバーのメモからであろうと、AIツールがその結果をどこから入手したのかを確認できる必要がある。

- より良いUXと信頼性。先進的なテクノロジーは、ユーザビリティの必要性を否定するものではない。むしろ、それは、テクノロジーが斬新であれば一層重要になる。

- ビデオ、画面、Webカメラの映像を処理できる機能。これらの視覚情報を処理できないツールでは、ユーザビリティテストを分析することは不可能だ。書き起こしだけでテスト分析ができると主張するツールを信用してはならない。

- 正確で信頼できる宣伝文句。AI調査ツールが主張するそのメリットの多くが、いかに不正確で誤解を招くものであるかを目の当たりにして我々は失望している。

AIツールは、間違いなく、近い将来のUX調査において、大きな役割を果たすことだろう。しかし今のところは、大げさな主張に注意する必要がある。AIを利用した調査ツールにお金を払うことを決める前に、必ずリクエストしてデモを試すようにしよう。ツールが生成する結果や提案には慎重になり、その作業内容をダブルチェックすることだ。そして、ダブルチェックが不可能な場合、そのAIツールは使用しないほうがいいだろう。

参考文献

Schwartz, R., Vassilev, A., Greene, K., Perine, L., Burt, A. and Hall, P. (2022), Towards a Standard for Identifying and Managing Bias in Artificial Intelligence, Special Publication (NISTSP), National Institute of Standards and Technology, Gaithersburg, MD, [online], https://doi.org/10.6028/NIST.SP.1270

記事で述べられている意見・見解は執筆者等のものであり、株式会社イードの公式な立場・方針を示すものではありません。