説明可能なAI (XAI)

XAIにはユーザへの説明を可能にすることでAIをユーザフレンドリにしようという側面もあり、AIのユーザビリティに関わる。XAIは使いやすいAIを目指すことで、人間とAIとの距離を縮めることに貢献するだろう。

XAIという考え方

今回は、説明可能なAI (以下XAI: eXplainable Artificial Intelligence)という考え方について書くことにする。XAIにはユーザへの説明を可能にすることによりAIをユーザフレンドリにしようという側面もあり、AIのユーザビリティに関わるともいえる。

OpenAIのChatGPTのような場合には、AIは人間にわかりやすい説明をしてくれるが、これは知識や情報を対話的に提供するタイプのAIであり、何らかの決定場面で人間の支援をしてくれるものではない。AIの利用場面にも様々なものがあり、たとえばパラメータが多すぎて人間には判断が困難な場面、あるいは人間の疲労を軽減したり人件費を削減するために人間が不在の状況で、人間に代わって判断をしてくれるタイプのAIもある。

こうしたAIでは、その判断を盲信してしまうような人は別として、どうしてAIがそういう判断に至ったかを知りたいと思うのが普通の人間の気持ちだろう。いわば、ブラックボックスと化してしまったAIの内側を覗きたいという気持ちに応える「人にやさしい」AIの登場への期待を具体化したものがXAIである。いいかえればユーザブルでユースフルなAIという方向である。

XAIという名称は、2004年にレント達(Lent et al. 2004)によって作られた。Google Trendsによると、XAIないしexplainable AIという言葉は、図1にみられるように、2016年ころから急速に利用されることが多くなっている。関連した研究論文も2016年を境に急増している。

DARPA (編注:アメリカ国防高等研究計画局)も2017年にはXAIプログラムの開発に着手した。DARPAによると「XAIは、高水準の学習能力(予測の正確さ)を維持しつつ、より説明力のあるモデルを提供するものである。また人間のユーザに新世代の人工知能パートナーを効果的に提供し、理解や適切な信頼を可能にするものである」ということになる。

XAIの適用分野

XAIの適用分野は多々考えられるのだが、特に次にあげる交通、医療、法曹、投資、軍事が代表的なものといえるだろう。

- 交通 自動運転車両(autonomous vehicle)では、事故が起きてしまった場合、どのような理由で特定の判断(急ブレーキをかけるとか、急ハンドルを切るなど)を下したのかを説明してくれることが必要だ。なお、咄嗟の事故が起きる直前にどうすべきかという情報を説明してくれても間に合わないので、運転中に説明をさせることは無理だろう。

- 医療 患者にどのような治療を施すべきか、どのような薬を投与すべきか、隔離すべきか否か、などについては昔から研究はされてきたが、医療チームのミーティングの際にXAIのデータを判断材料の一つとする方向が検討されつつある。

- 法曹 どのような罪状にどのような罰則を科すかという問題へのバランスのとれた判断とコスト削減にXAIは活用されうる。特に被告の性別や人種にかかわる予断や偏見のない公平な判断を下す上で参考になるだろう。ただし研究事例は少ない。

- 投資 株式投資への判断やローンの査定など、説明を必要とする場面は多い。しかし、ローンの借り手に対してどのような理由で承認されなかったのかを説明するような場面では、正直に説明すべきかどうかを判断することも必要だろう。

- 軍事 DARPAがXAIに関心を持ったのも、この分野への適用を考えていたからである。軍事では、作戦の立案やタイミング、部隊の配置、補給物資の配分など、意思決定にかかわる事態が多く、また生と死に拘わることが多い。おとり作戦の場合のように倫理的なジレンマに直面することもある。

- その他 サイバーセキュリティ、教育、エンタテイメント、行政、画像認識など、様々な場面にXAIは応用されうる。

XAIの概念構造

従来のエキスパートシステムでは、推論の連鎖をたどることによって完全な説明が可能ではあったが、柔軟性に欠け、人間に把握できる量的限界を超えてしまい、困難で使いにくいものだった。ニューラルネットによる深層学習では有効な結果をだすことはできたが、多数のレイヤ間の非線形な相互作用を解きほぐしてその中を見ることは実質的に不可能だった。

そこで、XAIというアプローチが登場したわけだが、恵木(2020)は、XAIを、従来の幅広い機械学習モデルを説明するブラックボックス(真っ黒)型と,学習過程や構造が人にとって解釈可能な新しいタイプの機械学習モデルであるトランスペアレント(透明)型とに区別している。恵木の論文は前者に力点を置いているが、このU-Siteで有意味なのは後者であろう。そこでは、事象をいかに説明するかということと、与えられた説明が人間に解釈できるかという人間のメンタルプロセスが関係してくるからだ。

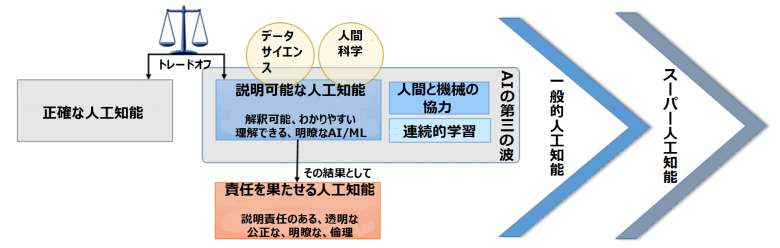

XAIには関連するキーワードが多数でてくるが、アダディとベラーダ(2018)は図2のように、それらを整理している。機械学習(ML)の領域では、説明可能という表現より解釈可能という表現がよく用いられてきたが、解釈可能であろうとするとブラックボックス性を排除しようとするあまり正確さを損ねてしまう場合もある。つまり、説明可能で解釈可能であることは分かりやすく理解しやすく明瞭であるというメリットがある反面、そこに話を作り上げてしまうような部分が入り、結果として正確さを損なうことがありうる。つまり正確さとの間にはトレードオフの関係があるということになる。

この点については、アリエタ達(2020)も、XAIは、(a) 高い学習能力(すなわち正確な予測)を維持しつつ、より多くの説明可能なモデルを生成すること、(b) 人間に対して、人工知能のパートナーという新たな世代を理解し、適切に信頼し、効果的に扱えるようにすることが必要で、そのためには社会科学からの洞察を得たり、説明の心理学を考慮することが重要である、と書いている。

また、XAIは、クリティカルな実社会の問題に関係してくると「責任を果たせるかどうか」ということも重要になってくる。いわゆるアカウンタビリティである。こうした諸概念の関係については、図2の「説明可能な人工知能」から「責任を果たせる人工知能」に至る矢印などを参照していただきたい。

説明できることと理解できること

まだ発展途上のトランスペアレント型XAIであるが、そこで重要になってくるのが社会科学、特に心理学、さらにいえば認知心理学の知見である。この観点で考えると、説明できることと理解できることの間には大きな違いがある。

説明にあたっては、それを受け取る人の能力はあまり問われない。ともかく事象を所定の基準にしたがって嚙み砕いた情報にする、ないしは関連した情報を提供すればよいのだ。情報の受け手をユーザと考えた時、ユーザの特性や利用状況に関することは、基本的には必要とされない。したがって説明については、ユーザ側には提供された情報を読解する一定の能力が求められることになる。

しかし、理解はユーザ側の問題であり、理解できる情報になっているかどうかはユーザの特性や利用状況によって異なる。ユーザの理解力や経験値なども考慮して回答を生成する必要があるから、システムは回答を作り出す前にユーザの認知モデルを構築しなければならない。しかし、理解の認知心理学はまだ完璧になっていない。だからそのあたりは試行錯誤となる。

また、理解には感情や感性も関係している。有名な「アハ体験(Aha-Erlebnis)」はその一例で、困っていたことについての回答が急に見えたりもたらされたりしたときの体験、つまり「腑に落ちた」時の体験のことをいう。これには肯定的な感情も伴ってくる。こうした状態を生成できるAI、それが理解可能なAI (understandable AI)なのだ。また、その考え方は、前回までに説明したHCAI、つまり人間中心的AIにも関係しているのである。

XAIは使いやすいAIを目指すことによって、人間とAIとの距離を縮めることに貢献してくれるだろう。

参考文献

Adadi, A. and Berrada, M. (2018) “Peeking Inside the Black-Box: A Survey on Explainable Artificial Intelligence (XAI)”, IEEE Access 2018.2870052

Arrieta, A.B., Diaz-Rodriguez, N., del Ser, J., Bennetot, A., Tabik, S., Barbado, A., Garcia, S., Gil-Lopez, S., Molina, D., Benjamins, R., Chatila, R., and Herrera, F. (2020) “Explainable Artificial Intelligence (XAI): Concepts, taxonomies, opportunities and challenges toward responsible AI”, Information Fusion 58, pp.82-115

恵木正史 (2020) XAI (eXplainable AI)技術の研究動向、日本セキュリティ・マネジメント学会誌, 34(1) pp. 20-27

Guidotti, R., Monreale, A., Ruggieri, S., Turini, F., Giannotti, F., and Pedreschi, D. (2019) “A survey of methods for explaining black box models,” ACM computing surveys (CSUR), Vol. 51, No. 5, p.93

記事で述べられている意見・見解は執筆者等のものであり、株式会社イードの公式な立場・方針を示すものではありません。