A/Bテストの基礎

A/Bテストは、プロダクトのユーザーエクスペリエンスを段階的に改善しながら、ビジネス目標を効果的に達成する方法である。

A/Bテスト(スプリットテストともいう)は、広く普及しているUX調査手法で、さまざまな企業や業界で採用されている。この手法を用いて、企業にとって信頼性が高く、有意義で有益な結果を得るためには、A/Bテストを計画し設定する際に、ベストプラクティスに従い、よくある間違いを避けることが重要である。

A/Bテストとは

A/Bテストとは、実際のユーザーを対象に2つ以上のデザイン案をテストし、あらかじめ設定したビジネス上の成功指標に基づいて、どのデザイン案が最も効果的かを判断する定量的調査手法である。

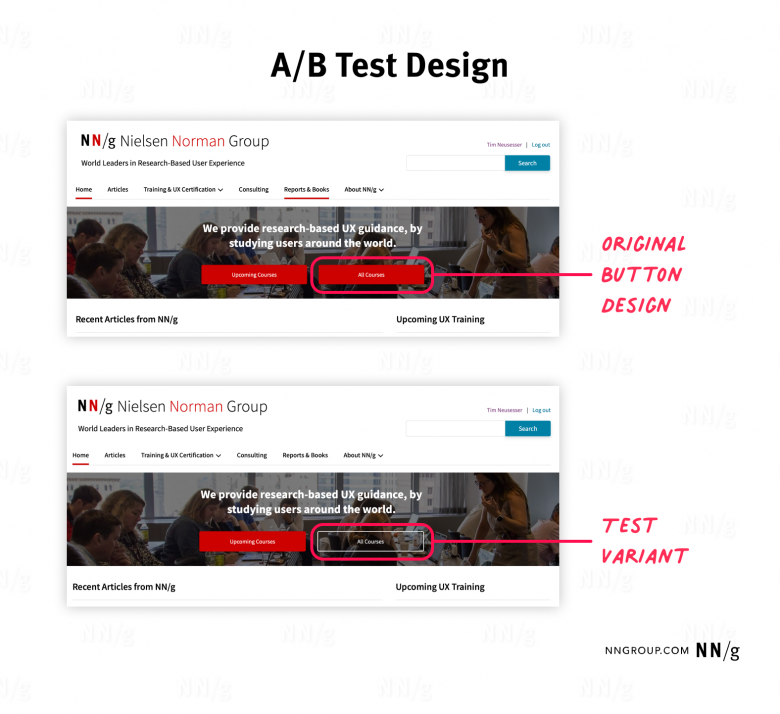

A/Bテストでは、運用中のプロダクトで2つ以上のデザイン案を作成する。最も一般的な方法は、元のデザインA(コントロールバージョンともいう)と、そのバリエーションB(バリアントともいう)を比較するものだ。理想的には、バリアントは元のデザインと、ボタン、画像、説明文などのデザイン要素のどれか1つのみが異なるようにデザインされるべきである。

A/Bテストでは、プロダクトにアクセスしてくる実際のユーザーのトラフィックが分割され、訪問者はそれぞれ、1つのデザイン案にのみ誘導される。このトラフィックの分割は、各デザイン案が同じ割合のトラフィックを受け取るようにもできるし、ビジネス上の目標やリスクに応じて調整することも可能だ。(たとえば、サイトのトラフィックの半分で変更案をテストするのはリスクが高すぎる場合など)。

そして、トラフィックが各デザイン案に割り当てられたら、一連の指標を収集し、どのデザイン案が望ましいユーザー行動を促し、それによって自社のビジネス目標をよりよくサポートできるかを判断する。

多くの場合(ただし、すべてではない)、バリアントの指標が統計的に有意に元のデザインを上回った場合は、そのバリアントをプロダクトの新しいデザインとして採用すべきである。一方、テストの結果が明確でなかった場合、または元のデザインが変更案を上回った場合は、元のデザインをそのまま使用すべきだ。その際には、さらに別のデザイン案をテストすればより良い結果が得られる可能性があるかどうかも検討する必要がある。

A/Bテストを実施する理由

A/Bテストは、UXチームが自社のビジネス目標に最適なユーザーエクスペリエンスの改善点を特定するのに役立つ。また、この手法によりデータに基づくデザイン上の意思決定が可能になり、投資収益率の向上につながる。さらに、A/Bテストに基づくそうした意思決定は、定性的な調査から得られる知見よりもステークホルダーに伝えやすいものだ。

A/Bテストは、デザインを継続的に改善する効率的な手法でもある。大規模なデザイン変更を行うことなく、段階的にプロダクトのユーザビリティと有効性を向上させることが可能だからである。

一般的なユースケース

A/Bテストでは、変更案が元のデザインよりも優れているかどうかを明確に示す、曖昧さのない指標が必要である。この指標は、収益やコストなど、金銭的な側面に焦点を当てたものであることが多い。A/Bテストでよく用いられる指標には、コンバージョン率、クリック率、直帰率、顧客維持率、ユーザーあたりの収益などがある。

A/Bテストが頻繁に実施され、それによって大きな影響と高い投資収益率がもたらされている業界やプロダクトには、以下のようなものがある:

- eコマース(例:Amazon)

- エンターテインメントプロダクト(例:Netflix、Spotify)

- ソーシャルメディア(例:Facebook、Instagram、TikTok)

- SaaS(例:Salesforce、Office 365)

- オンライン出版(例:The New York Times)

- Eメールマーケティング

これらの業界で最もよくテストされるデザイン要素には、以下のようなものがある。

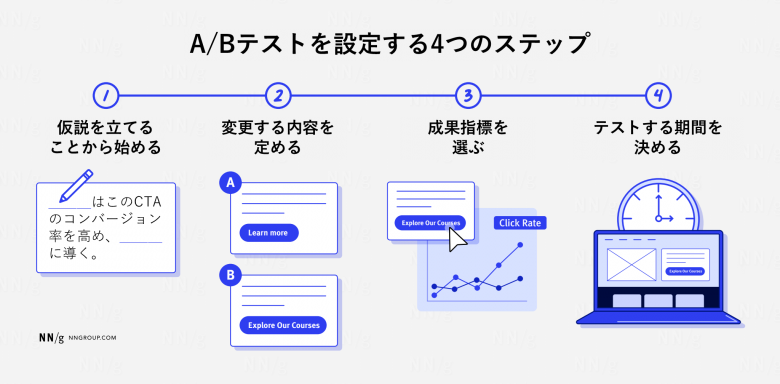

A/Bテストの設定のための4つのステップ

以下に概説する4つのステップに従うことで、信頼性が高く、有意義で、かつ肯定的な結果をもたらすテストを実施できる可能性が高まるだろう。

1. 仮説を立てることから始める

A/Bテストを始める前に、どの変更がどのような影響をもたらすかについての仮説を立てる必要がある。前述のとおり、この仮説がユーザー調査やビジネスに関する知見に基づいているほど、テストが成功する、つまりA/Bテストが期待どおりの結果となり、有意義なものになる可能性が高まる。仮説は、A/Bテストで達成したい明確な目標に直接結びついているべきである。

「例:eコマースサイトを運営している。定性的なユーザビリティテストで、複数の参加者が『購入』というラベルの付いたcall-to-action(CTA)ボタンに無関心なことがわかった。仮説として、そのページのデザインを変更すれば、このCTAのコンバージョン率が上がり、最終的に売上の増加につながると考えた」。

2. 変更する内容を定める

強力な仮説を立てたら、次にどのデザイン要素にどのような変更を加えるかを決め、仮説を検証する必要がある。これらの変更は、1つのデザイン要素のみに限定し、大規模なデザイン変更はしないものとする。繰り返しになるが、この決定がユーザー調査からの知見に基づいているほど、A/Bテストの結果が良好なものになる可能性は高まる。なぜなら、これらの知見は、アイデア出しのプロセスにプラスの影響を与えるからだ。

「例:定性的なユーザビリティテストから得られた知見に基づき、CTAボタンのラベルを変更することにした。テスト中に参加者はボタンを認識していたが、ボタンのメッセージが何を意味するのかわからないことが観察されたためである。そこで、ボタンのビジュアルデザインはそのままにして、ラベルを『今すぐ購入』に変更した」。

3. 成果指標を選ぶ

次にA/Bテストの影響と成功を判断するために、追跡する指標を明確に定義するとよい。主要な指標を定義することで、デザイン変更案が期待通りのユーザー行動の変化をもたらしているかどうかを判断できる。さらに、ガードレール指標を定義して追跡することで、その行動変化がビジネスに本当にプラスの影響を与えているかどうかを判断することも重要だ。

「例:CTAのラベルを『今すぐ購入』に変更することで売上が増加するかどうかを把握するため、CTAのクリック率を追跡することにした。さらに、購入率と1回の購入あたりの平均販売額も追跡していく。このようなガードレール指標を設定することで、デザイン変更案によるクリック率の増加がビジネスにプラスの影響を与えるかどうかを判断できる」。

4. テストする期間を決める

強力な仮説を立て、変更内容と追跡する指標を定義したら、A/Bテストをどのくらいの期間実施するかを決定する必要がある。この期間は、テストに必要なサンプルサイズによって決まる。

テストに必要なサンプルサイズを決定するためには、以下の3つの数値を定義する必要がある:

- 基準となる成果指標の値:デザインの成果指標(例:コンバージョン率、クリック率)。

- 最小検出可能効果:成果指標の基準値に対して、検出可能にしたい最小の相対変化量。

- 統計的有意水準(通常95%):テスト結果が信頼できると確信できる度合い。

この3つの指標を定義したら、サンプルサイズ計算ツールを使用して、A/Bテストに必要なサンプルサイズを算出することができる。十分なトラフィックがある場合でも、ユーザー行動の変動の可能性を考慮し、A/Bテストは最低でも1~2週間は実施することを推奨する。

「例:アナリティクスデータを使用して、購入CTAの基準となるクリック率が3%であると判断した。そして、最小検出可能効果を20%と設定した(つまり、変更案では、基準となる3%のクリック率の20%にあたる±0.6%の変化、すなわち2.4%~3.6%のクリック率を検出できるようにしたいということ)。また、テストでは95%の統計的有意性(p=0.05)を確保することとした。サンプルサイズ計算ツールを使用したところ、必要なサンプルサイズは13,000ユーザーであることがわかった。このウェブサイトの1日あたりの平均ユーザー数は1,000人であることから、A/Bテストを14日間実施し、十分なサンプルサイズを得る一方で、ユーザー行動の変動が生じる可能性もカバーできる期間を確保するようにした」。(訳注:上のリンク先で計算すると、「バリエーションごとのサンプルサイズ:13,000」と表示される。そのため、元のデザインAとバリエーションBそれぞれで13,000、つまり計26,000ユーザーが必要かもしれない)

なお、最小検出可能効果を決定する際には、成果指標のどの程度の変化がビジネスにとって実質的に重要であり、その変化にかかるコストに見合う価値があるのかを自問すべきである。たとえば、このサイトの場合、その変化を1%に設定したとすると、現在のクリック率よりわずか0.03%大きいかどうかを検出できるようにするということだ。このような小さな差異について統計的に有意な結果を得るには、非常に大きなサンプルサイズが必要となる。また、0.03%の変化はビジネスへの影響がごくわずかで追求する価値がない可能性もある。

A/Bテストツールを選ぶ

A/Bテストを調査手法の1つとして取り入れることにしたのなら、どのツールを使用するかを選択する必要がある。幅広い選択肢が存在するが、理想的なツールはコンテキストに大きく依存し、それぞれの状況やニーズによって異なる。自分たちのA/Bテストに最適なツールを選ぶ際には、以下の要素を考慮しよう:

- 予算:A/Bテストツールの価格は、無料のものから月額数千ドルのものまでさまざまである。

- テストの複雑さ:テストしたいデザイン案の変更内容がどの程度シンプルなのか、あるいは複雑なのかを考えよう。色や文言の単純な変更のみをサポートするものから、ページレイアウトの複雑な変更、多変量テスト、URL分割テストが可能なものまで、ツールによって対応できる複雑さのレベルは異なる。

- 使いやすさ:あなたとチームが無理なく新しいツールの使い方を習得でき、その後、そのツールを使ってA/Bテストを設定・運用する十分な時間を割けることを確認しよう。

- 技術的要件:ツールが自社の技術インフラとシームレスに統合できることを確認し、テストの作成にどれだけのエンジニアリング工数が必要かを慎重に検討しよう。

ニーズと要件に合いそうなツールを選択したら、最初のA/Bテストを実施する前に、そのツール自体をテストすべきである。このテストを行うことで、A/Bテストツールが正しく設定され、意図した通りに動作しているかを確認できる。そのための一般的な方法として、A/Aテストがある。これは、元のデザインとまったく同じバリアントを作成するというものである。

2つのまったく同じデザインを比較するテストをすると、明確な結論が出ない結果になるはずだ。もしそうならない場合は、テスト結果に差異が生じた原因を調査するべきである。この方法は、間違いや実装エラーを最小限に抑え、A/Bテストツールが最初のA/Bテストを実施する前に正しく設定されているかどうかを確認するのに役立つ。

A/Bテストの限界とよくある間違い

他の調査手法と同様に、A/Bテストにも限界がある。特定の状況下で正しく適用すれば非常に有益だが、誤って適用すればリソースの無駄遣いとなり、場合によっては有害な結果を招く可能性もある。

限界

A/Bテストは、以下の場合には適していない:

- トラフィックの少ないページ:A/Bテストで2つのデザイン案の間に統計的に有意な差を得るには、多くの場合、何千人ものユーザーがプロダクトとインタラクトする必要がある。そのため、A/Bテストはトラフィックの少ないページには適さない。

- 複数の変更を同時にテスト:A/Bテストは、複数のデザイン要素を同時に変更する変更案のテストには使用すべきではない。技術的には可能だが、個々の変更の影響を把握できなくなるからだ。複数の変更を一度にテストするには、多変量テストを使用するとよいが、このテストでは信頼性の高い結果を得るためにさらに多くのデータポイントが必要となることに留意すべきである。

- ユーザーの行動が変化した理由の把握:他の定量的調査手法と同様、A/Bテストはユーザー行動がどのように変化したかについての知見を得るには最適だが、その変化がなぜ起こったのかについての知見は提供しない。そのため、A/Bテストは定性的調査手法と組み合わせることで最も効果を発揮する。このやり方は三角測量(トライアンギュレーション)と呼ばれる。

A/Bテストでよくある間違い

A/Bテストの限界を無視し、ベストプラクティスに従わないと、誤解を招く結果や、場合によっては有害な結論を導き出してしまう可能性がある。回避すべきよくある間違いには、以下のようなものがある:

- 明確な目標の欠如:A/Bテストで期待される成果を得るためには、明確に定義された目標が必要である。この目標を立てることで、チームがテストの実施理由を共有でき、変更案作成のガイドラインが得られ、プロダクトで実行する各テストの期待される投資収益率を基準に、A/Bテスト全体のロードマップを構築できるようになる。

- テストを早期に終了:十分なデータポイントがないA/Bテストは、信頼性の低い結果をもたらす。それにもかかわらず、A/Bテストをリアルタイムで監視し、早すぎる段階で結論を出すという間違いを犯すチームもある。統計的に信頼性の高い結果を得るためには、そのテストに適したサンプルサイズに達するまで待つ必要がある。結論を出し、A/Bテストを終了するのは、そのときになってからである。

- 強力な仮説なしでのテスト:A/Bテストにおいて、変更案が元の案より統計的に有意な改善を示すのは7回に1回程度にすぎない。さらに、データに基づいた強力な仮説がないままデザイン要素をテストすると、この割合はさらに低下すると考えられる。プロトタイプや大規模なデザイン変更の場合と同様に、ユーザー調査から得た知見が豊富であればあるほど、プロジェクトが成功する可能性は高くなる。

- 1つの指標だけに注目:A/Bテストの目的は、多くの場合、特定の指標を増加または減少させることである。しかし、1つの指標のみを測定してテストが成功したかどうかを判断しようとすると、そのデザイン変更が組織にとって本当に有益であるかどうかを示す重要な情報を見落としてしまう可能性がある。たとえば、変更案に欺瞞的なパターンを使用した場合、コンバージョン率などの1つの指標にはプラスの影響があるかもしれないが、顧客維持率などの他の指標には思わぬ悪影響を及ぼす可能性がある。これが、ガードレール指標を含む複数の指標を追跡すべき理由であり、そうすることで変更案がもたらす真の影響についての知見を得ることができる。

- 定性調査やビジネスのコンテキストを無視:A/Bテストが統計的に有意な結果を示したからといって、それに盲目的に従うべきだとは限らない。そもそも、A/Bテストが偽陽性または偽陰性を示すこともあれば、測定エラーが発生することもありうるし、統計的に有意であっても実質的に有意でない結果が出ることも考えられるからだ。そのため、A/Bテストの結果をユーザーや組織に関する専門知識と組み合わせ、正しい結論を導き出すことが求められる。

記事で述べられている意見・見解は執筆者等のものであり、株式会社イードの公式な立場・方針を示すものではありません。